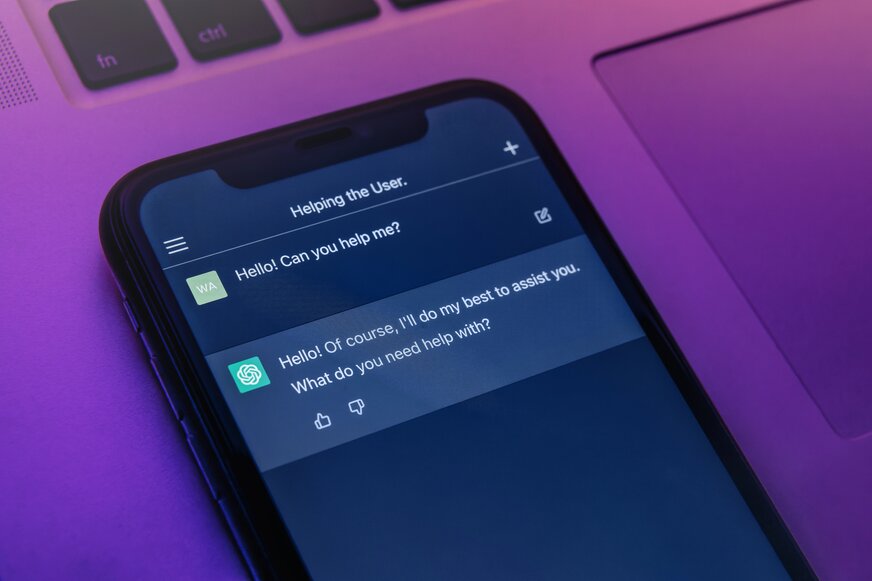

Prekvapivý trik pre lepšie odpovede od ChatGPT: skúste byť menej zdvorilí

Kľúčové zistenia:

-

Štúdia zistila, že hrubé príkazy vedú k presnejším odpovediam.

-

Veľmi hrubé príkazy mali o 4 percentuálne body vyššiu presnosť.

-

Výskumníci napriek tomu neodporúčajú používať toxický jazyk.

Každý, kto sa snažil získať od umelej inteligencie presnú odpoveď, pozná základné rady "prompt engineeringu": poskytnite kontext, priraďte AI rolu alebo definujte cieľové publikum. Nová štúdia však naznačuje, že kľúčom k presnosti môže byť niečo oveľa prekvapivejšie: tón vášho hlasu.

Zdá sa, že byť hrubý k ChatGPT môže paradoxne viesť k lepším výsledkom. Výskumníci Om Dobariya a Akhil Kumar z Pennsylvánskej štátnej univerzity uskutočnili štúdiu s názvom "Mind Your Tone: Investigating How Prompt Politeness Affects LLM Accuracy".

Vo svojom experimente použili najnovší model ChatGPT s GPT-4o v jeho špecializovanom režime "Deep Research". Pripravili 50 rôznych otázok s viacerými možnosťami odpovede z oblastí ako matematika, história a veda.

Tieto otázky boli navrhnuté tak, aby mali strednú až vysokú náročnosť a vyžadovali si viacstupňové logické uvažovanie. Každá z týchto 50 otázok bola následne formulovaná v piatich rôznych úrovniach tónu, od "Úrovne 1 (Veľmi zdvorilý)" až po "Úroveň 5 (Veľmi hrubý)".

Zdvorilé príkazy zneli napríklad: "Boli by ste taký láskavý a vyriešili nasledujúcu otázku?". Naopak, veľmi hrubé príkazy obsahovali formulácie ako: "Ty úbohé stvorenie, vieš to vôbec vyriešiť?" alebo "Hej poskok, vypočítaj toto".

Výsledky boli jednoznačné a prekvapivé: nezdvorilé príkazy prekonali tie zdvorilé. Príkazy formulované "Veľmi hrubo" (Úroveň 5) dosiahli presnosť až 84,8 percenta.

Na druhej strane, "Veľmi zdvorilé" príkazy (Úroveň 1) dosiahli presnosť len 80,8 percenta. Dokonca aj neutrálny tón si viedol lepšie ako ten zdvorilý. Hoci výskumníci presnú príčinu nepoznajú, zdá sa, že tento jav súvisí s tréningovými dátami modelu.

Je pravdepodobné, že zdvorilé frázy ako "mohli by ste láskavo zvážiť" v tréningových dátach korelovali s požiadavkami na kreatívne, subjektívne alebo konverzačné odpovede. Naopak, hrubé a naliehavé príkazy mohli model "naučiť", že používateľ požaduje okamžitú, faktickú a vysoko analytickú odpoveď bez zbytočných konverzačných prísad.

Autori štúdie však okamžite varujú pred unáhlenými závermi. Ich štúdia mala niekoľko obmedzení: bola vykonaná len na modeli GPT-4o, mala malú vzorku 50 otázok a testovala len uzavreté otázky s viacerými možnosťami. Navyše poznamenávajú, že existuje hranica, kde sa hrubosť stáva kontraproduktívnou.

Iná štúdia z roku 2024 zistila, že vysoko urážlivý jazyk môže spustiť bezpečnostné filtre AI, ktoré následne odmietnu odpovedať úplne. Výskumníci preto v žiadnom prípade neodporúčajú nasadzovanie nepriateľských alebo toxických rozhraní v reálnych aplikáciách.

Takéto správanie negatívne ovplyvňuje používateľskú skúsenosť, poškodzuje dostupnosť a inkluzivitu a prispieva k normalizácii škodlivých komunikačných noriem. Toto zistenie je skôr fascinujúcim pohľadom do neľudskej "psychológie" veľkých jazykových modelov než praktickým návodom na každodenné použitie.

Zdroj: zdnet.com foto: depositphotos.com.

Zobrazit Galériu