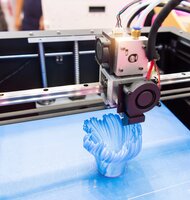

Aká je vaša zodpovednosť, ak používate kód generovaný umelou inteligenciou?

Väčšina programátorov používa SDK a knižnice kódu, ktoré osobne nepreverili ani neanalyzovali, ale napriek tomu sa na ne spoliehajú. Podľa právnika Richarda Santalesa, bude kód vytvorený umelou inteligenciou zatiaľ z hľadiska právnych dôsledkov v rovnakej pozícii. „Kým sa na súdoch neobjavia prípady, ktoré by túto otázku definitívne zodpovedali,“ hovorí Santales, „právne dôsledky kódu vytvoreného umelou inteligenciou sú rovnaké ako v prípade kódu vytvoreného človekom.“

Sean O'Brien, lektor kybernetickej bezpečnosti na Yale Law School a zakladateľ Yale Privacy Lab, poukázal na riziko pre vývojárov, ktoré je nesporne znepokojujúce: „Ak hovoríme o nástrojoch, ako sú ChatGPT a Copilot, ktoré boli vyškolené na obrovskom množstve open source aj proprietárneho kódu, je pravdepodobnosť, že prompty (programové príkazy) umelej inteligencie môžu vychádzať z proprietárneho kódu, veľmi vysoká.“

Nevieme, na čom boli chatboty vyškolené. A tak nevieme, či segmenty kódu poskytované ChatGPT a inými p ...

Článok je uzamknutý

Prihlásiť pomocou členstva NEXTECH

Zobrazit Galériu

Článok je uzamknutý

Pokračovanie článku patrí k prémiovému obsahu pre predplatiteľov. S digitálnym predplatným už od 10 € získate neobmedzený prístup k uzamknutému obsahu na celý rok. Objednať si ho môžete TU. Ak ho už máte prihláste sa TU

Prihlásiť pomocou členstva NEXTECH